Désolé, j’étais obligé ![]()

Hello à tous ! De retour avec mes petites expériences !

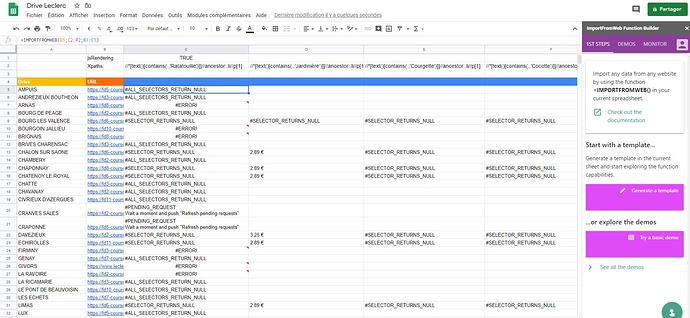

Pour info voici ce que j’ai obtenu de mieux en passant par la fonction importfromweb, avec une recherche de mes 20 produits :

• Premier problème → Il faut absolument exécuter le JsRedering sinon l’affichage des produits n’est pas généré

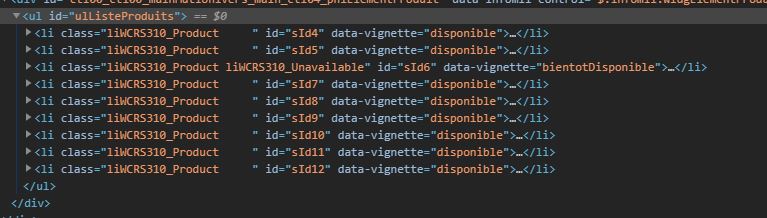

• Deuxième problème avec les xpath → il faut absolument trouver une correspondance avec le nom des produits. Sinon en utilisant les xpaths des balises ul, li, etc les prix et les noms de produits seront tous mélangés ou bien les ordres seront mélangés. Ex :

id=sID4 n’est pas forcement le même produit dans tous les drives. Cela dépend des produits dispo dans le drive.

Donc avec tout ça, on obtient des temps de chargement très long ce qui génère des erreurs. Sans compter le fait que les sites Drive Leclerc affichent très très souvent des pages de maintenant ou de mise en queue car le site est surchargé de visiteur. Pourtant quand cela fonctionne, c’est top !

Prochaine étape est de voir ça avec mon développeur pour une solution php

Salut Lunel et Tanguy,

Je suis aussi dans le monde du scraping depuis plus de 7 ans, et récupère déjà ce genre d’informations pour mes clients. D’expérience je vous conseillerais soit d’acheter les informations déjà prêtes, soit de passer par des prestataires connaissants très bien ce métier.

Vous pouvez très bien le faire avec vos développeurs bien sûr, mais s’ils ont peu d’expérience en scraping, notamment sur ce genre de marché, ça va exploser les coûts d’apprentissage et de maintenance. A savoir que les proxy fonctionnant bien sur ce genre de site sont parmis les plus chers aussi.

Toutefois rien d’impossible, pleins d’entreprises expertes le font, par contre il est vrai que c’est pas pour les débutants du scraping.

Petit up sur le sujet, avez-vous repéré des nouveaux outils, pu en tester certains ? Je dois faire certains relevés sur des sites spécialisés bio notamment et j’ai trouvé une palanquée d’outils, mais difficile de trouver le plus performant et le plus accessible (€).

Salut tout le monde,

@deude, si c’est un besoin ponctuel de temps en temps, tu peux utiliser la solution présentée par Lunel au dessus. C’est fastidieux mais pour du temps en temps ça marche bien.

Si c’est pour du besoin récurrent (genre quotidiennement), tu vas devoir mettre en place des solutions de scraping automatiques.

J’ai eu le même problème ![]() .

.

Si tu as des compétences informatiques : globalement il te faudra juste payer des bons proxys et passer du temps sur le dev (selon la protection des sites ça peut être long et compliqué, mais pas infaisable).

Si tu as peu de compétences informatiques, dans les outils de veille tarifaire je n’ai rien trouvé de potable à moins de 100 euros/mois . Ce qui est hors-budget pour moi ![]()

Du coup je me suis fait ma propre solution maison, ça marche correctement mais c’est artisanal ^^ …

Je suis en train de la mettre un peu au propre pour sortir une v1 d’ici 2-3 mois.

Selon tes prérequis (j’ai encore un peu de place sur mes proxys donc en gros si t’as une volumétrie pas trop élevée ![]() ) je peux intégrer tes scans dans ma v1 (winwin betatesteur

) je peux intégrer tes scans dans ma v1 (winwin betatesteur ![]() ). Mp moi si ça t’intéresse.

). Mp moi si ça t’intéresse.

Si tu as des gros besoins, malheureusement il faut passer à la caisse auprès des gros acteurs de veille tarifaire secteur.

A + !

Ah oui une autre solution intermédiaire si tu as des compétences informatiques c’est aussi de passer par des gens qui scrapent déjà les sites qui t’intéressent et qui te fournissent une API pour juste récupérer les résultats.