Ce n’est pas mon sujet ni mon comparatif, mais au vu de ta remarque, j’ai envie de te répondre a mon tour et rebondir sur le lien que tu a donné

Ce que tu dis est juste (pour la partie envoie des emails), mais étant donné que Mailnjoy est aussi référencé dans ton test de délivrabilité, j’ai moi-même noté plusieurs biais dans celui ci que je pense intéréssant de soulever.

- Tout d’abord le coté « juge et parti » :

En effet qd on décide de faire un test de délivrabilité et qu’on choisi soi-même judicieusement les adresse emails sur lesquelles on va envoyer, alors il est facile de trouver celles qui mettront en valeur sa propre solution, tout en évitant soigneusement celles qui sont plus problématiques. Ainsi n’importe lequel des outils benchmarqué peut indiquer qu’il a 97 ou 99% de réussite sur le test dans ces conditions la, et forcément les autres passent pour ceux qui savent moins bien faire. (Je pourrais facilement faire la même chose sur une liste soigneusement choisi sur Mailnjoy et montrer que les autres outils, dont le tiens, font nettement moins bien)

- Choix du type des adresses emails utilisés pour le test

Ton outil c’est spécialisé dans la validation des adresses professionnelles sur domaines catchall, mais ça ne représente pas du tout l’ensemble des boites emails existantes.

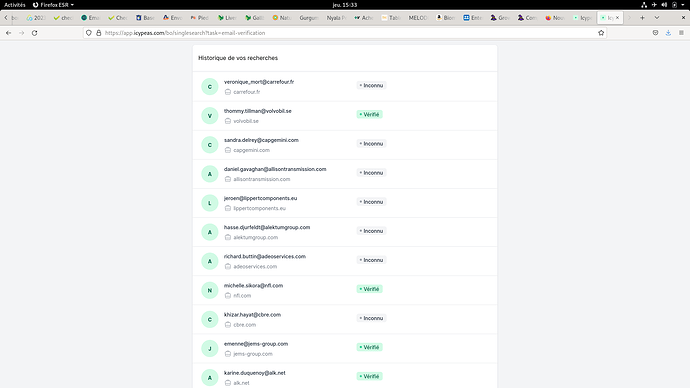

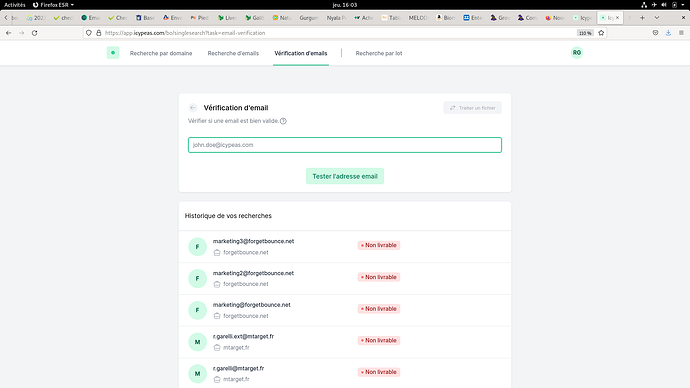

J’ai testé ton outils il y a 1 mois de ça environ sur un ensemble de boites emails classqiues (orange, sfr, laposte, yahoo, etc) et le score de validation était plus de l’ordre de 0% que de 100% (j’ai pas mal d’imprim écran si tu veux y jeter un oeil)

Donc la encore le 97% évoqué est un biais de jugement, sur un extract précis de boites email, professionelles choisies, et non pas représentatif d’une liste classiques emails ou il y aura un peu de tout (B2B ou B2C, même sur emails pro car bien des TPE utilisent par ailleurs des adresses « perso » pour un usage pro)

- Manière de classifier qu’un outils a des résultats « faux positif » ou « faux négatif »

Dans ton test, tu indique le pourcentage de faux positif / faux négatif de chaque solution. Pour cela tu considère qu’un faux positif est qd une adresse est identifié en « catchall » ou « protégé » alors que l’adresse email réelle d’une personne n’est pas celle que avais au préalablement identifié. Par exemple tu sais que « Jean Moulin » travaille chez « société X », et connaissant le pattern des emails classiques de cette société, tu en déduis que l’adresse réelle est par exemple [email protected] (et donc que [email protected] est un faux positif, même si celle ci ne génère pas de bounce)

Une boite email en fonctionnement « catchall » peut etre constitué d’alias, de redirection, et de multiples aspects technique qui font qu’il est malgré tout possible que [email protected] soit retransmis en interne vers [email protected]. C’est également possible que cette adresse redirige vers une boite générique du genre [email protected], et que quelqu’un la lise ensuite (ou pas…).

Donc techniquement parlant la réponse « catchall » est correcte, même si elle est moins précise que si elle est couplée a des croisements sur les noms/prénom des personnes via des api qui shootent sur linkedin. Ici on confond donc validité technique et valeur de confiance d’une adresse email, qui sont deux aspects différents (complémentaires, mais différents), et le fait d’attribuer un faux négatif est en tout cas un choix personnel et en rien une valeur absolue de la réalité.

A l’identique, les adresses emails « protégées » (qui peuvent avoir des interprétations totalement différentes d’un vérificateur email a un autre), sont (en tout cas chez Mailnjoy) présentes pour indiquer le possible risque de bounce. Chez bcp de comparateurs ces adresses la sont basiquement vues en « catchall », alors que c’est faux et elles peuvent générer des bounces. Chez Mailnjoy ont les classent en protégées afin d’identifier ce risque et de donner un % de bounce de celles ci. Cette spécificité ne collant pas avec les retours des autres outils, c’est tout bonnement classé en faux positif / faux négatif sans plus de discernement dans ton benchmark.

- Granularité des résultats et affinage

Ton benchamark regarde si l’adresse emails existe (ou plutôt si une personne est associé a cette adresse email sur une société donné) ou non, et donc un score de bounce supposé sur celle ci.

On parle ici d’estimation du taux de bounce d’une adresse email, mais des solutions (dont Mailnjoy) permettent de quantifier le fait qu’une adresse email valide puisse aussi être a faible valeur ajoutée (email jetable, pattern autogénéré sur des gros domaine public pour de l’usage unique, mots clés a faible confiance dans le username, absence d’activité internet du domaine ou se situe l’email, etc…)

Au final les solutions qui donnent plus de détails ici et qui vont plus loin que la simple validité « technique » d’un email ne sont pas prises en compte, alors que ce sont des éléments différenciant qui intéresse bcp les utilisateurs et qui devraient donc être pris en compte dans ton benchmark si tu veux qu’il soit plus représentatif de la réalité.

- fraicheur de la data renvoyée

Ton outils se base sur des données froides, je suppose avec des liens croisés de bigdata collecté sur des API linkedin (ou apparentée).

Je ne te demande pas de nous donner la recette de cuisine, chacun la sienne  , mais une chose est sure, tu ne fais pas de call SMTP pour déterminer les résultats. Comme tout bon technique, j’aime a benchamrker les concurrents en regardant comment ils se comportent pour valider des adresses emails perso / pro dont je dispose, et j’ai vu qu’il n’y a aucun call SMTP qui est effectué pour valider les emails en questions.

, mais une chose est sure, tu ne fais pas de call SMTP pour déterminer les résultats. Comme tout bon technique, j’aime a benchamrker les concurrents en regardant comment ils se comportent pour valider des adresses emails perso / pro dont je dispose, et j’ai vu qu’il n’y a aucun call SMTP qui est effectué pour valider les emails en questions.

L’immense majorité des validateur email se base d’abord sur du SMTP pour vérifier les adresses, et agrémentent de données diverses pour aller plus loin, mais en ayant pris soin de vérifier deja le statut réel de la boite a l’instant T.

Ton outils n’effectue pas ces call SMTP et renvoi des informations sur des données croisées annexes, ce qui a fait que dans un de mes essais par exemple j’ai eut une adresse email pro d’une boite que j’ai quitté il y a 6 ans deja (et dont l’adresse n’existe plus depuis ce moment la) qui est remonté valide à 97% de confiance avec ton outils. Ceci démontre que les données ne sont pas suffisantes fraiches et risquent dans bien des cas de donner ce type de problème la. En comparaison bcp des outils que tu a bencharké (dont le mien) font des vérifications systématiques, ce qui est un point relativement important, et qui n’est pas pris en compte dans ton bench.

- Non utilisation des spécificités technique des concurrents :

Par exemple ici, nous disposons chez Mailnjoy d’une validation approfondie qui permet de vérifier avec encore plus de points de contrôle une adresse email, et gagner en fiabilité sur sa possibilité de bounce et sur son intéret marketing (= présence d’un vrai humain qui utilise la boite et pas juste une boite automatisée qui n’a pas d’activité réelle derrière). Zerobounce et d’autres vérificateurs ont également des fonctionnalités du genre, mais ton benchmark ne tiens pas en compte de ces aspects la.

Je comprend que ça serait plus complexe de benchmarker en prenant en compte tous ces aspects la qui sont propre a chaque solution, mais le fait de ne pas le faire diminue fortement le coté impartial du bench que tu présente, qui met en avant ta solution comme étant LA meilleure et de loin, la ou la réalité est qd même tout autre si on regarde aussi les différents aspects que j’ai remonté ici.

Ta solution est surement intéréssante et innovante, mais convient a des usages qui ne sont pas universel (plutôt même assez spécifiques), et chaque solution a ses forces et ses faiblesses, selon les usages que l’on en fait…