J’ai récemment publié deux projets Python sur GitHub qui permettent d’extraire facilement et rapidement des listes d’URL d’entreprises et de profils à partir de LinkedIn.

Les liens :

3 « J'aime »

interessant !

peux tu integrer une API de proxy dans ton script ?

comment ca se passe il faut installer cela sur sa machine et niveau proxy comment ca fonctionne ?

merci

Piloterr est l’API qui fait office de proxy et parser html !

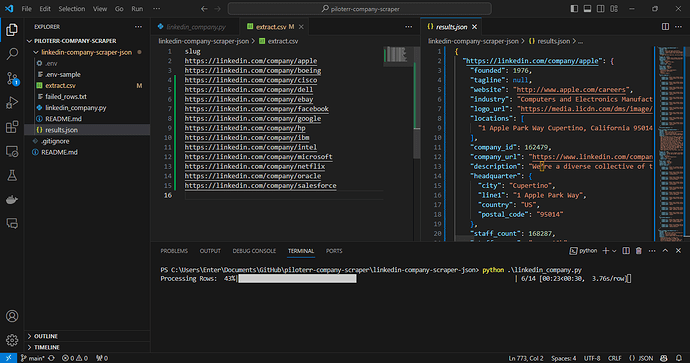

Tu git clone le repo sur une machine

Tu ajoutes une API key dans le .env et modifie le thread, par ex si tu as +300k lignes à crawler, je te conseille un thread de 5 pour aller plus vite

Tu ajoutes les profiles et ou companies dans le extract.csv

Tu lances le script avec la commande python linkedin_xxxx.py

Notre service va faire office de proxy pour aller chercher la data et la parser

A la fin tu récupères un JSON normalisé dans results.json

J’explique tout ici linkedin-company-scraper/linkedin-company-scraper-json at main · piloterr/linkedin-company-scraper · GitHub

1 « J'aime »

merci ! je teste ce soir

qu’est ce que ca fait de plus qu’un : Vayne : Linkedin Scraper & Email Enrichment to focus on selling par exemple ?

Si je résume « simplement »

Lequel choisir : je ne sais pas ça va dépendre du use-case (input/output)

1 « J'aime »

en version public tu es limitée dans tes recherches de toute facon non ?

ben tu ne peux pas scapper plus de 100 pages de 25 resultats…

Les scripts Python fonctionne avec ton service Piloterr on est d’accord ?

Oui ils utilisent notre infrastructure !

etal

Février 6, 2024, 9:38

12

Tu devrais comparer la performance entre ThreadPoolExecutor et asyncio.gather avec un sémaphore

Oui j’ai vu… Je vais re-dev pour qu’il y est un « vrai » thread!

1 « J'aime »

![]() Nous utilisons notre solution de collecte de données et de proxies en raison des restrictions de LinkedIn qui empêchent l’accès aux robots. En ce qui concerne le coût des proxies, par exemple, pour 45€, vous pouvez extraire 20 000 pages.

Nous utilisons notre solution de collecte de données et de proxies en raison des restrictions de LinkedIn qui empêchent l’accès aux robots. En ce qui concerne le coût des proxies, par exemple, pour 45€, vous pouvez extraire 20 000 pages.